-

Physique: les "Dr Frankenstein" de l'IA, ces étranges "Prix Nobel" qui renient leur propre "créature"

Du rififi dans l'IA...

"Je suis particulièrement

fier que l'un de mes étudiants

ait viré Sam Altman"

Geoffrey Hinton,

Prix Nobel, ce 8 Octobre 2024

https://x.com/JMannhart/status/1843831370352865711

Geoffrey Hinton, considéré comme le "parrain" principal fondateur de l'IA, et aujourd'hui Prix Nobel en compagnie d'un autre chercheur de la génération précédente, et dont il s'est inspiré, prend explicitement position contre les dangers de leur "invention" et contre les dérives qu'elle commence déjà à entraîner, et qui menacent de plus nettement l'avenir de l'humanité, non seulement à travers son utilisation guerrière, mais aussi et surtout à cause de sa capacité à s'autonomiser et à échapper complètement au contrôle de l'humanité, et de plus, avec des capacités "intellectuelles" éventuellement largement supérieures.

A cette occasion il a explicitement renouvelé sa défiance à l'égard de Sam Altman, actuellement le principal (ir-)responsable de ChatGPT, en exprimant sa reconnaissance à l'un de ses ex-étudiants, devenu co-responsable de cette entreprise OpenAI, et qui a tenté de "déboulonner" Sam Altman de son poste, avant de finalement quitter l'entreprise pour fonder la sienne propre, sur la base des codes éthiques proposés par Geoffrey Hinton pour tenter de limiter les risques de "dérapages" de l'IA.

Actuellement, bien que Geoffrey Hinton ait alerté sur la possible utilisation, à l'avenir, de l'IA par une puissance militaire telle que la Russie de Vladimir Poutine, la réalité actuelle c'est d'ores et déjà son utilisation par Israël pour la "planification" de ses massacres de civils à Gaza, en Palestine en général, et maintenant, au Liban!

Et en France même, l'invasion médiatique de ChatGTP est déjà largement avancée, et son influence sur notre pays a précisément pris un nouveau tournant, aujourd'hui même, avec la création d'un bureau OpenAI ("ChatGPT") à Paris, avec une mention particulière de ce même Sam Altman...

Luniterre

Nobel de physique:

le duo récompensé sonne l'alarme

sur l'intelligence artificielle

Mis à jour aujourd'hui à 00h19par AFP

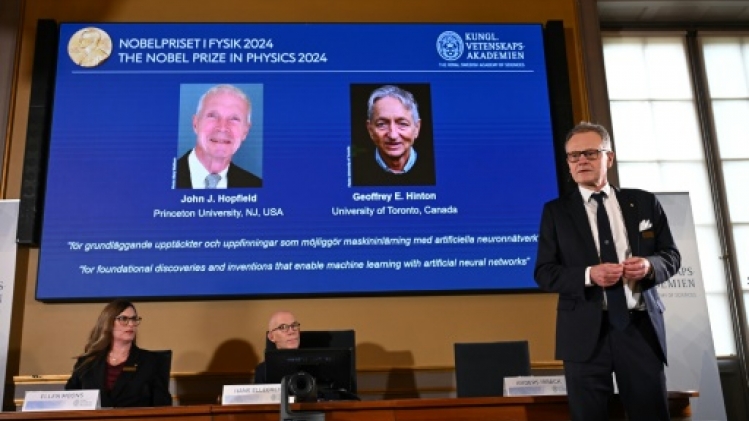

Le Britanno-canadien Geoffrey Hinton et l'Américain John Hopfield, récompensés mardi du prix Nobel de physique pour leurs travaux respectifs dans "l'apprentissage automatique", cruciaux pour le développement de l'intelligence artificielle (IA), ont sonné l'alarme sur cette technologie.

Les lauréats ont mené des recherches dans les réseaux de neurones artificiels dès les années 1980, ouvrant la voie aux promesses de l'IA, révolution technologique qui suscite des inquiétudes y compris chez ses inspirateurs.

"Je crains que la conséquence globale de tout cela ne soit des systèmes plus intelligents que nous, qui finissent par prendre le contrôle", a déclaré à la presse après l'annonce Geoffrey Hinton.

Le chercheur, âgé de 76 ans et professeur à l'université de Toronto au Canada, est considéré comme l'un des pères fondateurs de l'intelligence artificielle. Il a annoncé son départ de Google en mai 2023 pour pouvoir alerter sur les dangers de l'IA.

En mars 2023, interrogé par une télévision américaine sur les "risques que l'intelligence artificielle anéantisse l’humanité", il avait répondu que "ce (n'était) pas inimaginable".

John Hopfield, 91 ans, est lui professeur à la prestigieuse université Princeton.

Les deux chercheurs "ont utilisé des outils de la physique pour développer des méthodes qui sont à la base des puissants systèmes d'apprentissage automatique d'aujourd'hui", a indiqué le jury dans son communiqué.

Ils sont distingués "pour leurs découvertes et inventions fondamentales qui permettent l'apprentissage automatique grâce aux réseaux neuronaux artificiels". Ces réseaux s'inspirent du réseau de neurones dans notre cerveau.

Ils "ont utilisé des concepts fondamentaux de la physique statistique pour concevoir des réseaux de neurones artificiels qui fonctionnent comme des mémoires associatives et trouvent des modèles dans de grands ensembles de données", a précisé Ellen Moons, présidente du comité Nobel de physique, devant la presse.

- "Très troublé"-

Ces modèles "ont été utilisés pour faire avancer la recherche dans des domaines aussi divers que la physique des particules, la science des matériaux et l'astrophysique, et ils font désormais partie de notre vie quotidienne" comme la reconnaissance faciale et la traduction automatique, a-t-elle poursuivi.

L'apprentissage automatique "présente d'énormes avantages" mais "son développement rapide a également suscité des inquiétudes quant à notre avenir", a-t-elle reconnu.

M. Hopfield a donné son nom au "réseau Hopfield", c'est-à-dire "une mémoire associative qui peut stocker et reconstruire des images et d'autres types de modèles", selon le jury.

L'annonce du Nobel lui est parvenue "dans une chaumière où il séjourne en Angleterre", a indiqué l'université de Princeton dans un communiqué.

Lui aussi a appelé à une meilleure compréhension de l'intelligence artificielle, pour l'empêcher de devenir incontrôlable, qualifiant les dernières avancées en la matière de "très inquiétantes".

"En tant que physicien, je suis très troublé par quelque chose qui n'est pas contrôlé, quelque chose que je ne comprends pas assez bien pour savoir quelles sont les limites que l'on peut imposer", a-t-il déclaré par lien vidéo à une assemblée réunie à son université.

M. Hinton est, lui, parti du réseau Hopfield pour créer un nouveau réseau utilisant une méthode différente: "la machine Boltzmann".

Il a ainsi "inventé une méthode capable de trouver de manière autonome des propriétés dans les données, et donc d'effectuer des tâches telles que l'identification d'éléments spécifiques dans des images".

- "Je suis ébahi"-

"Je suis ébahi... Je n'imaginais pas que cela puisse arriver", a-t-il réagi. Interrogé sur son outil préféré dans le domaine de l'IA, M. Hinton a reconnu être un grand utilisateur de ChatGPT, tout en admettant qu'il était préoccupé par ses répercussions.

Le Premier ministre canadien Justin Trudeau l'a félicité sur X. "Geoffrey, nous sommes heureux de pouvoir compter sur un esprit comme le vôtre", a-t-il déclaré.

Grâce à leurs travaux, l'humanité a maintenant un nouvel instrument dans sa boîte à outils, "que nous pouvons choisir d'utiliser à de bonnes fins", a souligné le comité Nobel.

Décernés depuis 1901, les prix Nobel distinguent les personnes qui ont œuvré pour "le bienfait de l'humanité", conformément au vœu de leur créateur, l'inventeur suédois Alfred Nobel.

Le Nobel de chimie sera décerné mercredi, avant le prix Nobel de littérature jeudi et le prix Nobel de la paix vendredi à Oslo. Le prix Nobel d'économie, décerné pour la première fois en 1969, sera attribué lundi 14 octobre.

Le lauréat du Nobel remporte un chèque de onze millions de couronnes suédoises (plus de 970.000 euros).

**********************************************************************************************************************************************************************

"Fier qu'un de mes étudiants l'ait licencié":

le Nobel de Physique tire à boulets rouges sur Sam Altman, le patron de ChatGPT

Thomas Leroy

Le 09/10/2024 à 12:12

Surnommé le "parrain de l'intelligence artificielle", Geoffrey Hinton n'a pas caché son antipathie pour le patron d'OpenAI.

Rares sont les prix Nobel qui finissent par regretter leurs travaux. Geoffrey Hinton, co-lauréat avec John Hopfield du prix Nobel de Physique pour leur apport dans le domaine de l'intelligence artificielle, en fait partie. Surnommé le "parrain de l'IA", le chercheur n'en finit plus d'alerter sur les dérives potentielles des modèles.

Dans son viseur, la bête noire de ceux qui critiquent l'explosion soudaine de ChatGPT: Sam Altman, le patron d'OpenAI. Lors d'une série de questions réponses avec l'Université de Toronto ce 8 octobre, le très vénérable Geoffrey Hinton s'est donc payé le tout puissant patron par une remarque acerbe.

"Je voudrais remercier mes étudiants. J'ai été particulièrement chanceux d'avoir eu beaucoup d'étudiants brillants, bien plus brillants que moi" a-t-il lancé. "Ils ont fait des choses incroyables. Et je suis particulièrement fier qu'un de mes étudiants ait licencié Sam Altman."

Il fait alors référence à Ilya Sutskever, un des fondateurs d'OpenAI, qui a tenté de renverser, en vain, Sam Altman l'année dernière. Si le Conseil d'administration avait bien réussi à le mettre à la porte, il avait finalement été contraint, sous la pression des employés et des actionnaires, à le réintégrer. Ilya Sutskever a, depuis, quitté l'entreprise, comme beaucoup d'autres.

Les profits plutôt que la sécurité

L'origine du conflit est résumé par Geoffrey Hinton: "avec le temps, il s'est avéré que Sam Altman était beaucoup moins préoccupé par la sécurité que par les profits. Et je pense que c'est dommage."

"OpenAI a été mis en place avec un fort accent sur la sécurité. Le premier objectif était de développement une intelligence artificielle générale et de garantir qu'elle serait sûre" a-t-il souligné.

Fondé en 2015 notamment par Sam Altman et Elon Musk, OpenAI est effectivement passé d'une organisation à but non lucratif à une startup lucrative valorisée à 150 milliards de dollars, grâce à Sam Altman. Au point que de fortes dissensions apparaissent au sein de l'entreprise sur le degré de sécurité mis en place.

"Mon inquiétude est que l'IA peut aussi conduire à de mauvaises choses" insiste Geoffrey Hinton. "En particulier quand nous fabriquons des choses plus intelligences que nous même. Personne ne sait vraiment si nous allons pouvoir les contrôler."

Thomas Leroy - Journaliste BFM Business

***********************************************************************************************************************************

**********************************Geoffrey Hinton, often hailed as the "godfather of AI," has openly expressed reservations about Sam Altman’s leadership of OpenAI, criticising Altman for focusing more on profits than safety. Hinton, who recently won the 2024 Nobel Prize in Physics, mentioned his pride in one of his former students, Ilya Sutskever, for playing a pivotal role in Altman’s temporary removal from OpenAI in November 2023.

Hinton's concerns are rooted in his long-standing commitment to the ethical development of AI. In 2009, Hinton demonstrated the potential of Nvidia’s CUDA platform by training a neural network to recognise human speech, an achievement that contributed to the wider use of GPUs in AI research. His research group at the University of Toronto continued to push the boundaries of machine learning, ultimately developing a neural network in 2012 with students Ilya Sutskever and Alex Krizhevsky. This network was capable of identifying everyday objects like flowers, dogs, and cars by analysing thousands of images. This breakthrough validated the use of GPUs in AI, and soon, competitors were adopting neural networks powered by GPUs across the board.

Sutskever's influence extended well beyond his academic accomplishments. As a co-founder and chief scientist at OpenAI, his technical leadership helped shape some of the organisation's most advanced AI models. However, after OpenAI’s board ousted Altman as CEO in late 2023, Sutskever initially supported the decision, only to later regret his actions and join others in advocating for Altman’s reinstatement. Sutskever eventually left OpenAI in May 2024 to start his own AI venture, Safe Superintelligence Inc.

Hinton, who supervised Sutskever during his Ph.D. at the University of Toronto, reflected on OpenAI’s original mission, which was heavily focused on ensuring the safety of artificial general intelligence (AGI). Over time, however, he observed a shift under Altman’s leadership towards a profit-driven approach, a change Hinton views as detrimental to the organisation's core principles.

Beyond his critique of OpenAI, Hinton has long warned about the dangers AI poses to society. He has expressed concerns that AI systems, by learning from vast amounts of digital text and media, could become more adept at manipulating humans than many realise. Initially, Hinton believed that AI systems were far inferior to the human brain in terms of understanding language, but as these systems began processing larger datasets, he reconsidered his stance. Now, Hinton believes AI may be surpassing human intelligence in some respects, which he finds deeply unsettling.

As AI technology rapidly advances, Hinton fears the implications for society. He has warned that the internet could soon be flooded with AI-generated false information, leaving the average person unable to discern what is real. He is also concerned about AI's potential impact on the job market, suggesting that while chatbots like ChatGPT currently complement human workers, they could eventually replace roles such as paralegals, personal assistants, and translators.

Hinton’s greatest concern lies in the long-term risks AI poses, particularly the possibility of AI systems exhibiting unexpected behaviour as they process and analyse vast amounts of data. He has expressed fears that autonomous AI systems could be developed to run their own code, potentially leading to the creation of autonomous weapons, or "killer robots." Once dismissing such risks as distant, Hinton now believes they are much closer than previously thought, estimating they could materialise within the next few decades.

Other experts, including many of Hinton’s students and colleagues, have described these concerns as hypothetical. Nonetheless, Hinton is worried that the current competition between tech giants like Google and Microsoft could spiral into a global AI arms race, one that would be difficult to regulate. Unlike nuclear weapons, AI research can easily be conducted in secret, making regulation and oversight much harder. Hinton believes that the best hope for mitigating these risks lies in collaboration among the world’s top scientists to devise methods of controlling AI. Until then, he argues, further development of these systems should be paused.

Hinton’s concerns about Altman’s leadership are not unique. Elon Musk, another co-founder of OpenAI, has been a prominent critic of Altman, particularly regarding OpenAI’s transition from a nonprofit to a for-profit organisation. Musk has repeatedly pointed out that this shift runs counter to the company’s original purpose of being an open-source, nonprofit initiative to counterbalance other tech giants.

As the AI race continues, Hinton’s warnings underscore the growing divide between technological advancement and ethical responsibility, with OpenAI and its leadership at the centre of this tension.

****************************************************************************************************************************************

OpenAI: le créateur de ChatGPT s'installe à Paris

T.L avec AFP

Le 09/10/2024 à 9:29

La startup va ouvrir un bureau à Paris pour attirer les profils français de l'intelligence artificielle.

Après s'être installée à Londres et Dublin, la startup américaine OpenAI, créatrice du très populaire outil d'intelligence artificielle (IA) ChatGPT, va ouvrir un bureau à Paris, a-t-elle annoncé mercredi.

Cette présence doit permettre à OpenAI "d'accéder au vivier de talents français", a fait valoir l'entreprise dans un communiqué, ajoutant qu'elle commencerait bientôt à recruter.

"Avec une équipe sur place, nous pourrons collaborer étroitement avec les entreprises, institutions et développeurs français pour les aider à tirer pleinement parti des avantages de l'IA", a déclaré Sam Altman, cofondateur d'OpenAI.

L'entreprise a également annoncé son intention d'ouvrir des bureaux à Singapour, New York et Bruxelles plus tard cette année.

La France, acteur majeur du secteur?

"Ce choix reflète le dynamisme croissant de notre écosystème français d'intelligence artificielle, que nous voulons positionner comme un des leaders mondiaux", a salué de son côté la nouvelle secrétaire d'Etat chargée de l'Intelligence artificielle et du Numérique, Clara Chappaz, citée dans le communiqué.

Paris accueillera en février 2025 le prochain sommet international de l'IA, le Président Emmanuel Macron ayant pour ambition affichée de faire de la France un acteur majeur du secteur.

L'arrivée d'OpenAI se fera toutefois dans un contexte de bras de fer avec les journaux français.

Le développeur de ChatGPT a en effet refusé mi-septembre d'ouvrir des négociations avec deux organismes de la presse française pour utiliser de manière payante les contenus des 800 titres qu'ils représentent.

La start-up, valorisée à 157 milliards de dollars après une levée de fonds majeure de 6,6 milliards la semaine dernière, est aussi, comme tous les mastodontes du secteur de l'intelligence artificielle, dans le radar de Bruxelles.

L'Union européenne continue ainsi d'examiner le partenariat entre Microsoft et OpenAI et ses impacts sur la concurrence.

*********************************************************************************************************************************************************************

Sur le même sujet:

http://cieldefrance.eklablog.com/j-ai-teste-chatgpt-les-questions-qui-fachent-a215444145

**********************

*********************************************

**************

********************

Source de l'article et de la compilation:

******************************************

« "Radiation" du Pr Raoult: quelques précisions utilesLIBAN RESISTANCE ! Netanyahou veut détruire le pays, sauf capitulation, comme il a déjà détruit Gaza »

-

Commentaires

« Dans les boîtes à jouets des puissants de ce monde les cris des peuples sont inaudibles » - Eugène Sue - Les Mystères du Peuple - Postface inédite

-

Physique: les "Dr Frankenstein" de l'IA, ces étranges "Prix Nobel" qui renient leur propre "créature"

-

Commentaires